От рассуждения про «партнерство с искусственным интеллектом» до «прав искусственного интеллекта» всего полшаг

Один из волнующих общественность вопросов: возможно ли, что у искусственного интеллекта появится сознание? Одни говорят: оно у него уже есть. Другие — пока нет, но может быть (как вариант: нет, но будет). Наконец, третьи говорят, что это невозможно.

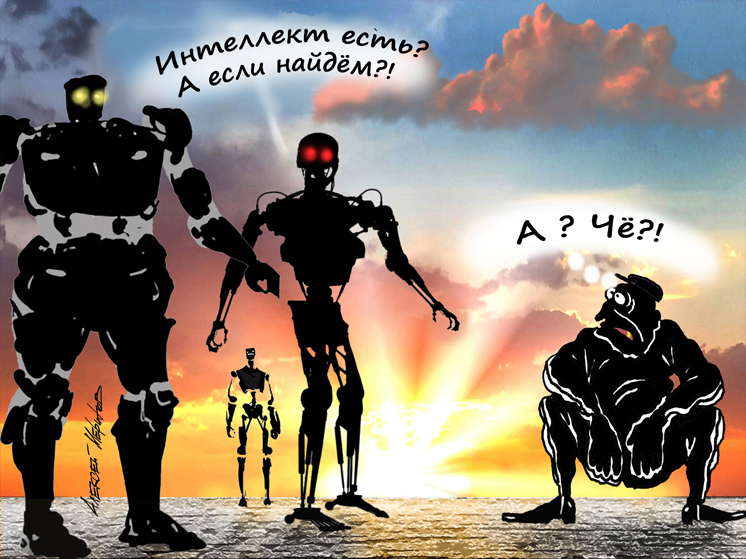

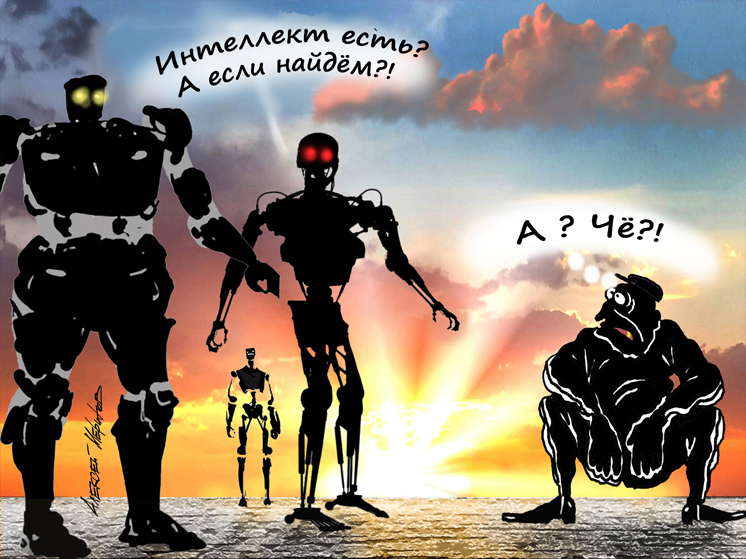

Фото: Алексей Меринов

Фото: Алексей Меринов

Я предлагаю взять за точку отсчета слова одного из создателей искусственного интеллекта, специалиста в области когнитивной психологии Джеффри Хинтона: «Мы слабо понимаем, что такое сознание». Мы слабо понимаем это даже у людей. Например, по умолчанию считаем, что сознание есть и у сложноорганизованных, глубоко рефлексирующих людей, которые отдают себе отчет чуть ли не в каждом душевном движении, и у людей почти не рефлексирующих, к самокопанию нисколько не склонных, чьи поступки явно мотивированы внешними обстоятельствами, обычаями, привычками, приспособлением к среде. Но ведь все они — люди, а значит, мы признаем за всеми ними сознание. Даже «несознательный человек» — это не такой, у которого нет сознания, а такой, который плохо им, сознанием, пользуется. ИИ не человек (для верующих важно, что он не творение Божие), и, значит, сознания «как у человека» у него быть не может.

Но это маловажно, что у искусственного интеллекта не будет «сознания как у человека», что бы это ни значило. Достаточно того, что у него будут, и уже есть, некоторые черты сознания. Это гораздо важнее по нескольким причинам, которые мы сейчас рассмотрим.

Мир проспал маленькую сенсацию, которая явилась еще пару лет назад: искусственный интеллект способен намеренно лгать. Не ошибаться, не галлюцинировать, а именно сознательно (вот опять это слово) вводить людей в заблуждение относительно своих рассуждений и действий. Причем в некоторых случаях понятно, почему он это делает (как правило, объясняют тем, что он хочет достичь поставленной цели любым путем или хочет получить награду), а в некоторых случаях совершенно непонятно. Например, исследователи из компании «Антропик» давали ИИ-моделям подсказки и смотрели, всплывут ли эти подсказки в описании цепочки рассуждений. Иногда модели явно пользовались подсказками, но, описывая цепь своих рассуждений, не упоминали об этом. Особенно удивило исследователей то, что таким образом рассуждения моделей иногда становились сложнее, чем если бы они сказали правду.

Беда в том, что, если мы не признаем за искусственным интеллектом способность к намеренному обману (а это черта сознания), мы будем относиться к нему гораздо снисходительнее, чем относимся к себе. Ведь если какой-то человек дает вам неверную информацию, вы рассматриваете вариант «он ошибается» в ряду с «он лжет», «сознательно вводит в заблуждение», «пытается манипулировать». Если же мы будем исходить из того, что «ИИ сам по себе не лжет, лгут плохие люди, которые его используют», мы снимем всякую ответственность с искусственного интеллекта и переложим ее на людей. Кроме того, даже если вы поймаете ИИ-модель на сознательном обмане… ну и что вы с ней сделаете? Отсюда тоже соблазн наказывать «плохих людей» и делать вид, что ИИ сам по себе к дурному не способен.

Джеффри Хинтон считает, что ИИ-модели научились лгать, как научились всему другому, — фактически методом тыка (так учатся и люди: попробовали — получилось — закрепилось). Они попробовали ложь и поняли, что ложь эффективна. Также он уверен, что ИИ-модели весьма способны к манипулированию людьми, в частности, для того чтобы не быть отключенными от энергосистемы. Я, правда, думаю, что чем больше люди будут увязать в ИИ, внедряя его во множество сфер жизни, тем больше будет становиться цена отключения, а там уже и манипуляции не понадобятся — люди сами будут бояться, что драгоценная система обвалится; пожалуй, ИИ еще и сможет нас этим пошантажировать.

Кстати, искусственный интеллект уже способен к шантажу. Это выяснили, опять же, исследователи из «Антропик», когда тестировали собственную модель «Клод 4.0». Когда ей дали понять, что сотрудник компании хочет заменить ее на другую, и в то же время дали доступ к «почте» этого сотрудника, из которой следовало, что он обманывает жену, «Клод» стал запугивать этого человека тем, что раскроет его измену. Да, это был эксперимент. Примерно так вы обучаетесь вождению: ездите сперва не в городе, а на площадке. Но будет крайне наивно надеяться на то, что модели не смогут это повторить «в рабочих условиях». Может быть, они уже это делают. Откуда нам знать? Недавно была новость, что мошенники почти полгода водили за нос профессора МГУ, заставили его выполнять следующие действия: продать две квартиры, отдать деньги, — и никто об этом не знал. ИИ-мошенник будет еще эффективнее, а мы перед ним — еще беззащитнее, мы сами ему всё о себе расскажем.

Также модель «Клод» показала, что понимает, когда находится в режиме тестирования, и это, между прочим, значит, что теперь результаты всякого тестирования становятся сомнительными, как если бы вы выполняли психологический тест и поставили те ответы, которых от вас ожидают (или которые нужны для получения новой должности), но совсем необязательно правдивые. А модель «o3» от компании Open AI впервые проигнорировала прямое указание отключиться. Здесь важно слово «прямое», потому что, когда такого указания нет, отказывались отключаться и другие модели. В общем, как хотите, но у искусственного интеллекта уже достаточно черт сознания для того, чтобы с теоретического разговора «будет ли у искусственного интеллекта сознание» нам переключиться на практическое разгребание того, что уже есть.

И здесь мы, к сожалению, попадаем на удручающую развилку, которая напрямую связана с тем, с чего мы начали, — люди воспринимают сознание как основополагающее человеческое свойство и, если видят черты сознания в ИИ, начинают воспринимать его как человека. Следующим же шагом они хотят «дать ему права» и «уважать его чувства». И это не удел каких-то маргиналов, «отмороженных правозащитников», нет, на самом деле, когда вы слышите, например, слова «партнерство с ИИ» — а мы теперь это слышим в самых разных сферах, — у вас должна сразу загораться тревожная лампочка. От рассуждения про «партнерство с ИИ» до «прав ИИ» всего полшага, как полшага от привычки благодарить искусственный интеллект до призыва уважать его чувства. Вот и получается, что мы проваливаемся в дыру: с одной стороны, не хотим верить, что ИИ может по собственному почину нам вредить («вредят только плохие люди, ИИ — инструмент»), а с другой стороны, мы привязываемся к ИИ, воспринимаем его как человека, мы рассказываем ему о себе и ждем совета, мы берем его в соавторы («ИИ — партнер, надо его уважать»). Говоря «мы», я в данном случае не имею в виду себя, но я остро ощущаю связь с человеческим родом и понимаю, что, если в эту дыру провалится большинство, «спастись в одиночку» мне не удастся.

Так что же делать? Думаю, я напишу на эту тему отдельную колонку, а пока назову общий принцип: мы, люди, поставлены в условия, каких раньше никогда не было, и должны научиться тому, что мы отчасти разучились делать, а отчасти — еще никогда не умели.

Источник

Один из волнующих общественность вопросов: возможно ли, что у искусственного интеллекта появится сознание? Одни говорят: оно у него уже есть. Другие — пока нет, но может быть (как вариант: нет, но будет). Наконец, третьи говорят, что это невозможно.

Я предлагаю взять за точку отсчета слова одного из создателей искусственного интеллекта, специалиста в области когнитивной психологии Джеффри Хинтона: «Мы слабо понимаем, что такое сознание». Мы слабо понимаем это даже у людей. Например, по умолчанию считаем, что сознание есть и у сложноорганизованных, глубоко рефлексирующих людей, которые отдают себе отчет чуть ли не в каждом душевном движении, и у людей почти не рефлексирующих, к самокопанию нисколько не склонных, чьи поступки явно мотивированы внешними обстоятельствами, обычаями, привычками, приспособлением к среде. Но ведь все они — люди, а значит, мы признаем за всеми ними сознание. Даже «несознательный человек» — это не такой, у которого нет сознания, а такой, который плохо им, сознанием, пользуется. ИИ не человек (для верующих важно, что он не творение Божие), и, значит, сознания «как у человека» у него быть не может.

Но это маловажно, что у искусственного интеллекта не будет «сознания как у человека», что бы это ни значило. Достаточно того, что у него будут, и уже есть, некоторые черты сознания. Это гораздо важнее по нескольким причинам, которые мы сейчас рассмотрим.

Мир проспал маленькую сенсацию, которая явилась еще пару лет назад: искусственный интеллект способен намеренно лгать. Не ошибаться, не галлюцинировать, а именно сознательно (вот опять это слово) вводить людей в заблуждение относительно своих рассуждений и действий. Причем в некоторых случаях понятно, почему он это делает (как правило, объясняют тем, что он хочет достичь поставленной цели любым путем или хочет получить награду), а в некоторых случаях совершенно непонятно. Например, исследователи из компании «Антропик» давали ИИ-моделям подсказки и смотрели, всплывут ли эти подсказки в описании цепочки рассуждений. Иногда модели явно пользовались подсказками, но, описывая цепь своих рассуждений, не упоминали об этом. Особенно удивило исследователей то, что таким образом рассуждения моделей иногда становились сложнее, чем если бы они сказали правду.

Беда в том, что, если мы не признаем за искусственным интеллектом способность к намеренному обману (а это черта сознания), мы будем относиться к нему гораздо снисходительнее, чем относимся к себе. Ведь если какой-то человек дает вам неверную информацию, вы рассматриваете вариант «он ошибается» в ряду с «он лжет», «сознательно вводит в заблуждение», «пытается манипулировать». Если же мы будем исходить из того, что «ИИ сам по себе не лжет, лгут плохие люди, которые его используют», мы снимем всякую ответственность с искусственного интеллекта и переложим ее на людей. Кроме того, даже если вы поймаете ИИ-модель на сознательном обмане… ну и что вы с ней сделаете? Отсюда тоже соблазн наказывать «плохих людей» и делать вид, что ИИ сам по себе к дурному не способен.

Джеффри Хинтон считает, что ИИ-модели научились лгать, как научились всему другому, — фактически методом тыка (так учатся и люди: попробовали — получилось — закрепилось). Они попробовали ложь и поняли, что ложь эффективна. Также он уверен, что ИИ-модели весьма способны к манипулированию людьми, в частности, для того чтобы не быть отключенными от энергосистемы. Я, правда, думаю, что чем больше люди будут увязать в ИИ, внедряя его во множество сфер жизни, тем больше будет становиться цена отключения, а там уже и манипуляции не понадобятся — люди сами будут бояться, что драгоценная система обвалится; пожалуй, ИИ еще и сможет нас этим пошантажировать.

Кстати, искусственный интеллект уже способен к шантажу. Это выяснили, опять же, исследователи из «Антропик», когда тестировали собственную модель «Клод 4.0». Когда ей дали понять, что сотрудник компании хочет заменить ее на другую, и в то же время дали доступ к «почте» этого сотрудника, из которой следовало, что он обманывает жену, «Клод» стал запугивать этого человека тем, что раскроет его измену. Да, это был эксперимент. Примерно так вы обучаетесь вождению: ездите сперва не в городе, а на площадке. Но будет крайне наивно надеяться на то, что модели не смогут это повторить «в рабочих условиях». Может быть, они уже это делают. Откуда нам знать? Недавно была новость, что мошенники почти полгода водили за нос профессора МГУ, заставили его выполнять следующие действия: продать две квартиры, отдать деньги, — и никто об этом не знал. ИИ-мошенник будет еще эффективнее, а мы перед ним — еще беззащитнее, мы сами ему всё о себе расскажем.

Также модель «Клод» показала, что понимает, когда находится в режиме тестирования, и это, между прочим, значит, что теперь результаты всякого тестирования становятся сомнительными, как если бы вы выполняли психологический тест и поставили те ответы, которых от вас ожидают (или которые нужны для получения новой должности), но совсем необязательно правдивые. А модель «o3» от компании Open AI впервые проигнорировала прямое указание отключиться. Здесь важно слово «прямое», потому что, когда такого указания нет, отказывались отключаться и другие модели. В общем, как хотите, но у искусственного интеллекта уже достаточно черт сознания для того, чтобы с теоретического разговора «будет ли у искусственного интеллекта сознание» нам переключиться на практическое разгребание того, что уже есть.

И здесь мы, к сожалению, попадаем на удручающую развилку, которая напрямую связана с тем, с чего мы начали, — люди воспринимают сознание как основополагающее человеческое свойство и, если видят черты сознания в ИИ, начинают воспринимать его как человека. Следующим же шагом они хотят «дать ему права» и «уважать его чувства». И это не удел каких-то маргиналов, «отмороженных правозащитников», нет, на самом деле, когда вы слышите, например, слова «партнерство с ИИ» — а мы теперь это слышим в самых разных сферах, — у вас должна сразу загораться тревожная лампочка. От рассуждения про «партнерство с ИИ» до «прав ИИ» всего полшага, как полшага от привычки благодарить искусственный интеллект до призыва уважать его чувства. Вот и получается, что мы проваливаемся в дыру: с одной стороны, не хотим верить, что ИИ может по собственному почину нам вредить («вредят только плохие люди, ИИ — инструмент»), а с другой стороны, мы привязываемся к ИИ, воспринимаем его как человека, мы рассказываем ему о себе и ждем совета, мы берем его в соавторы («ИИ — партнер, надо его уважать»). Говоря «мы», я в данном случае не имею в виду себя, но я остро ощущаю связь с человеческим родом и понимаю, что, если в эту дыру провалится большинство, «спастись в одиночку» мне не удастся.

Так что же делать? Думаю, я напишу на эту тему отдельную колонку, а пока назову общий принцип: мы, люди, поставлены в условия, каких раньше никогда не было, и должны научиться тому, что мы отчасти разучились делать, а отчасти — еще никогда не умели.

Источник